Cyrille MAGNE |

Daniele SCHÖN |

Corine ASTÉSANO |

Mireille BESSON |

|---|

Introduction

Nos recherches sont centrées sur le problème de la spécificité du langage. Pour aborder ce problème, nous avons choisi de comparer le langage avec une autre fonction cognitive qui présente évidemment des différences, mais également de nombreuses similarités avec le langage : la musique. Dans la première partie, nous placerons le problème de la spécificité du langage dans le contexte théorique des différentes approches linguistiques qui apportent, nous le verrons, des réponses antagonistes à ce problème. Dans la seconde, nous décrirons la méthode utilisée pour aborder ce problème. Enfin, dans une troisième partie, nous présenterons les résultats d’expériences ayant pour objectif de comparer directement certains aspects du traitement du langage, tels que la sémantique et la syntaxe, avec certains aspects du traitement de la musique tels que la mélodie, l’harmonie et le rythme. Nous terminerons en mentionnant de nouvelles ouvertures de recherche qui nous paraissent particulièrement intéressantes et excitantes.

Contexte théorique : la spécificité du langage

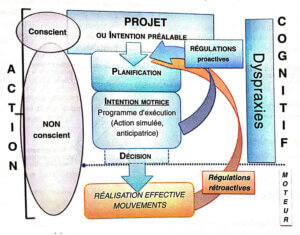

La théorie linguistique qui a exercé une influence prépondérante au cours des 50 dernières années est sans nul doute la théorie de la grammaire générative (GG) développée par Noam Chomsky, un des dix auteurs les plus cités en sciences sociales avec Freud, Marx et Platon. Un des points importants est qu’il existerait un organe du langage pour reprendre les termes de Chomsky (voir Pinker, 1994), spécialisé et indépendant des autres fonctions cognitives. Jackendoff (1994), un des élèves les plus célèbres de Chomsky, développe deux arguments fondamentaux en faveur de l’autonomie de la faculté de langage.

Le premier repose sur l’existence d’une grammaire mentale. Le fait que tout être humain normal puisse comprendre et créer un nombre infini de phrases dans sa langue maternelle, à partir d’un nombre fini de mots, implique que le cerveau humain contient des principes grammaticaux inconscients, qui lui permettent de décider que telle phrase est grammaticale alors que telle autre ne l’est pas.

Le second argument est celui d’une connaissance innée des principaux aspects de la grammaire. La rapidité avec laquelle les enfants apprennent à parler impliquerait que le cerveau soit génétiquement déterminé pour traiter le langage. Jackendoff (1994) décrit ainsi ce qu’il appelle le paradoxe de l’acquisition du langage : alors que tout enfant ayant un développement normal maîtrisera sa langue maternelle vers l’âge de 8-10 ans, et aura donc assimilé les principes qui régissent l’organisation de la langue, les linguistes les plus talentueux, aidés des ordinateurs les plus puissants, n’ont pas encore réussi à expliquer les principes grammaticaux qui président à la structuration des langues.

Cependant, cette conception selon laquelle la fonction de langage serait indépendante des autres fonctions cognitives a été contestée par certains auteurs. Certes, dans la chaîne de traitement qui va permettre d’extraire du sens à partir d’une série de signaux acoustiques ou visuels, certaines opérations sont probablement spécifiques au fait que ces signaux forment les mots d’une langue. Ces auteurs insistent néanmoins sur le fait que certaines opérations sont probablement communes au traitement d’autres signaux sonores ou visuels, organisés en fonction de règles structurales et fonctionnelles précises. Ainsi, les opérations nécessaires à la compréhension du langage ne seraient pas indépendantes de celles requises par la mise en jeu d’autres fonctions cognitives, comme la mémoire, l’attention, la catégorisation…

Afin de tester ces deux conceptions antagonistes de la fonction de langage, nous comparons langage et musique. L’intérêt pour cette comparaison n’est d’ailleurs pas nouveau, Jean-Jacques Rousseau s’élevait en fervent défenseur d’une origine commune au langage et à la musique, tout en accordant une primauté à la musique. Selon lui, les langues primitives étaient chantées, et non parlées. Elles avaient pour fonction d’exprimer des sentiments, la haine, l’amour, la colère ; elles étaient passionnées avant d’être raisonnées…

La méthode des potentiels évoqués

Cette méthode permet de mesurer directement, au moyen d’électrodes placées sur le scalp les variations de l’activité électrique cérébrale produites par la mise en jeu synchrone de milliers de neurones, en réponse à la présentations d’un événement particulier (un mot présenté sur un écran, un son, un accord de musique présentés au moyen de haut-parleurs ou d’un casque audio, etc…).

Le psychiatre allemand Hans Berger (1873-1941) fut le premier à étudier les variations de l’activité électrique cérébrale chez l’homme. Il baptisa la méthode électroencéphalogramme (EEG)

C’est cependant grâce aux nouvelles possibilités offertes par l’utilisation de l’informatique que l’on a pu résoudre les problèmes posés par la faible amplitude des variations de cette activité : ces variations sont d’une amplitude trop faible pour être détectées lors d’une seule stimulation. Il faut donc à la fois amplifier le signal, et présenter plusieurs essais appartenant à la même condition expérimentale, les sommer puis les moyenner, afin que les variations synchrones de la présentation du stimulus émergent du bruit de fond constitué par l’électrogenèse corticale. (voir fig. 1).

On obtient alors le potentiel électrique évoqué par la présentation du stimulus, potentiel qui comprend généralement plusieurs composantes, définies par leur polarité (négative, N, ou Positive, P), leur latence d’occurrence par rapport au début de la stimulation (e.g., N100 est une composante négative, dont le maximum d’amplitude apparaît 100 millisecondes après le début de la présentation du stimulus), et leur distribution topographique sur le scalp. Ces différentes composantes sont supposées refléter les différentes étapes du traitement de l’information apportée par le stimulus. La méthode des PEs permet ainsi de suivre le décours temporel des processus neurophysiologiques qui sous-tendent nos activités mentales en temps réel. Elle est utilisée pour son excellente précision temporelle (de l’ordre de la milliseconde). En revanche, la résolution spatiale des PEs est médiocre puisqu’il reste très difficile de déterminer avec certitude la position, dans le cerveau, des générateurs qui sont à l’origine des effets observés sur le scalp. En d’autres termes, le problème inverse est insoluble car le nombre de solutions est infini, comme démontré par Helmholtz, le célèbre physicien allemand.

En revanche, les nouvelles techniques d’imagerie cérébrale (TEP : tomographie par émission de positrons ; IRMf : imagerie par résonance magnétique fonctionnelle) sont fondées sur la mesure du débit sanguin cérébral ; elles permettent de localiser avec une précision de l’ordre de quelques millimètres les zones cérébrales les plus activées lors d’une tâche, mais la précision temporelle des décours des activations reste par contre très médiocre.

Les expériences

Elles ont pour but de comparer le langage avec une autre activité typiquement humaine, la musique. Langage et musique présentent évidemment plusieurs différences dont deux paraissent fondamentales.

La première est liée à leur fonction sociale

Le langage a une fonction de communication : il joue un rôle crucial dans l’organisation des sociétés humaines. La possibilité de combiner à l’infini des mots pour exprimer des idées nouvelles semble spécifique au langage humain.

La musique, quant à elle, permet d’exprimer et d’évoquer des émotions, du plaisir. En cela, elle assure aussi la cohésion du groupe social.

La seconde différence fondamentale entre langage et musique est liée au problème de la sémantique musicale

Quelle est la signification de la musique ? La question est d’une grande complexité et la diversité des réponses est telle qu’il serait déplacé d’en faire une revue exhaustive. Il semble, cependant, que de nombreux auteurs soient d’accord pour considérer la musique comme un système auto-référencé, en ce sens que, contrairement au langage, compris par référence à un système extra-linguistique, il n’existe pas de référence extra-musicale. La musique n’est pas rivée à des significations, ni directes, ni symboliques ; la musique est un langage qui se signifie soi-même (Arom, 2000 ; Jakobson, 1973 ; Meyer, 1957).

Ces deux systèmes présentent également des similarités intéressantes : ce sont deux systèmes d’expression, partagés par toutes les cultures, et qui sont, en outre, spécifiques à l’homme.

Langage et musique reposent sur une organisation séquentielle d’événements qui se déroulent dans le temps. Ils impliquent, en outre, plusieurs niveaux de représentation. On s’accorde ainsi à différencier les niveaux orthographique, phonologique, prosodique, sémantique, syntaxique et pragmatique dans le langage, et les niveaux de notation musicale rythmique, mélodique et harmonique dans la musique.

Les expériences réalisées portent précisément sur la comparaison entre ces différents niveaux de traitement.

Sémantique et mélodie

En analysant les potentiels évoqués lors de la lecture de phrases, terminées par des mots sémantiquement congruents ou incongrus (par exemple : Il porte sa fille dans ses bras/narines*1), Kutas & Hillyard (1980) ont démontré l’occurrence d’une composante négative, présentant un maximum d’amplitude sur les régions centro-pariétales du scalp, 400 ms environ après le début de la présentation visuelle des mots incongrus, d’où son nom : N400 (voir figure 2). En revanche, les mots congruents, fortement attendus dans le contexte phrastique, ne sont pas associés à une N400. Depuis cette expérience princeps, de nombreux travaux ont permis de montrer que la composante N400 serait un bon indice des relations sémantiques entre un mot et le contexte linguistique dans lequel il est présenté.

Afin de déterminer si une composante de type N400 est également présente dans la musique, Besson & Faïta (1995) ont mené une nouvelle série d’expériences auprès de musiciens et non-musiciens auxquels on présentait des mélodies familières ou non familières, terminées par une note juste, une note hors de la tonalité de la phrase musicale ou une note dans la tonalité mais peu attendue dans le contexte musical. Les résultats montrent que les incongruités musicales suscitent l’occurrence d’une composante positive tardive (P600), mais pas d’une composante N400 (voir figure 3). Notons toutefois que l’amplitude et la latence de cette composante positive varient en fonction du niveau d’expertise, de la familiarité de la mélodie et du degré d’incongruité : elle est plus ample et plus précoce pour les musiciens que pour les non-musiciens, pour les mélodies familières que pour les mélodies non familières et pour les incongruités fortes, notes hors de la tonalité, que pour les incongruités faibles, notes dans la tonalité. Il serait évidemment intéressant de faire écouter une mélodie japonaise à un auditeur occidental !

Ainsi, les résultats obtenus montrent que la composante P600 est sensible à des facteurs qui influencent fortement la perception musicale

Ces résultats soulignent également que des processus différents sont mis en jeu dans le traitement de certains aspects sémantiques du langage et mélodiques de la musique. Ils sont donc compatibles avec l’idée, rapidement évoquée ci-dessus, que la musique n’a pas, au sens strict du terme, de signification, de contenu propositionnel.

Syntaxe et harmonie

La musique est un système structuré selon des règles quasiment mathématiques. Il existe ainsi une grammaire musicale, constituée par les règles de l’harmonie et du contrepoint. L’existence d’une grammaire musicale souligne donc une similarité importante avec le langage. Dans les deux cas, un ensemble de règles détermine les constructions qui sont autorisées et celles qui ne le sont pas. Cependant, il ne s’agit peut-être que d’une analogie de surface, une métaphore attirante mais sans fondement théorique. Le but des expériences décrites ci-dessous est précisément de déterminer les limites de cette analogie.

Concernant les aspects syntaxiques du langage, Osterhout & Holcomb (1992) ont montré que la présentation de phrases dont la structure grammaticale est ambiguë ne suscite pas l’occurrence d’une composante N400, mais d’une composante positive plus tardive atteignant son maximum d’amplitude sur les régions postérieures du scalp vers 600 ms, baptisée P600. La P600 se développe entre 500 et 900 ms dans la modalité visuelle.

Afin de comparer directement l’effet de violations structurales dans le langage et la musique, Patel, Gibson, Ratner, Besson & Holcomb (1998) ont introduit des violations de la structure syntaxique dans le langage et de la structure harmonique dans la musique. Les résultats n’ont pas révélé de différences significatives (polarité, distribution topographique) entre les deux types de positivités (P600), ce qui suggère qu’elles reflètent des processus similaires (voir figure 4). Ainsi, le traitement des règles qui gouvernent la structuration de séquences d’éléments ferait appel à des processus communs, que les éléments soient de nature linguistique ou musicale.

Rythme

Nous avons réalisé une expérience visant à comparer directement l’effet d’une pause inopportune entre l’avant-dernier et le dernier mot d’une phrase parlée, et d’un silence inattendu entre l’avant-dernière et la dernière note d’une phrase musicale (Besson, Faïta, Cztermasty & Kutas, 1997). Les résultats montrent que dans les deux cas, l’incongruité rythmique suscite l’occurrence d’un potentiel émis, qui prend la forme d’un complexe biphasique, négatif (N200) puis positif (P300 ; voir figure 5). Ainsi, l’absence d’un mot ou d’une note à un moment attendu en fonction du rythme de la phrase linguistique ou musicale suscite l’occurrence d’un effet dont l’amplitude varie, en outre, en fonction de la familiarité des phrases musicales et linguistiques (proverbes) : il est plus ample lorsqu’elles sont familières que lorsqu’elles ne le sont pas. Ces résultats nous permettent donc de souligner que des processus similaires seraient mis en jeu par le traitement d’incongruités rythmiques dans la musique et le langage. Un processeur commun pourrait être responsable de l’analyse de la structure temporelle de séquences organisées, que ces séquences soient constituées de mots formant des phrases ou de notes formant une mélodie.

Conclusion

La comparaison des processus impliqués dans la compréhension du langage et la perception de la musique permet de mettre en exergue des similarités et des différences selon les différents aspects considérés. Les résultats obtenus grâce à la méthode des potentiels évoqués montrent que le traitement de certains aspects sémantiques du langage est associé à des effets électrophysiologiques qualitativement différents de ceux associés au traitement de certains aspects mélodiques et harmoniques de la musique. Alors qu’une composante N400 se développe suite à la présentation d’un mot sémantiquement inattendu, une composante P600 est enregistrée en réponse à la présentation d’une note ou d’un accord mélodiquement ou harmoniquement inattendu. Les opérations cognitives qui président à l’accès au sens d’un mot semblent donc spécifiques au traitement sémantique, même si celui-ci ne se réduit pas au langage. Ces opérations diffèrent néanmoins de celles requises par le traitement des aspects mélodiques et harmoniques de la musique.

En revanche, le traitement de certains aspects syntaxiques du langage est associé à des effets électrophysiologiques qualitativement similaires à ceux associés au traitement de certains aspects harmoniques de la musique. Une composante P600 se développe aussi bien après la présentation d’un mot syntaxiquement inattendu qu’après celle d’un accord qui n’appartient pas à la tonalité d’une séquence musicale. Ils soulèvent ainsi la possibilité que le traitement des aspects syntaxiques du langage et harmoniques de la musique relève d’un mécanisme commun qui aurait pour fonction l’analyse des aspects structuraux d’une séquence d’événements organisés, que celle-ci comprenne les mots d’une phrase ou les accords d’une mélodie. Des conclusions similaires peuvent être tirées de la comparaison de certains aspects du traitement prosodique dans le langage et rythmique dans la musique.

Les interprétations en termes d’un mécanisme commun au traitement des aspects structuraux du langage et de la musique doivent néanmoins être considérées avec prudence au moins pour deux raisons. La première tient à la spécificité des aspects considérés. Le traitement syntaxique du langage ne se réduit pas aux opérations nécessaires à la compréhension de phrases dont la complexité structurale varie du simple au complexe, de l’attendu à l’inattendu (Patel et al., 1998). De même, l’étude du traitement du rythme dans la musique n’est qu’approché grossièrement par la manipulation que nous avons introduite : un silence de 600 ms entre deux notes d’une phrase musicale. Il faut donc étoffer ces résultats par des expériences complémentaires, que nous réalisons actuellement, visant à étudier d’autres aspects des traitements syntaxiques et harmoniques, d’une part, et prosodique et rythmique, d’autre part.

La deuxième raison est liée au fait que ces interprétations en termes de communauté de traitement sont en grande partie basées sur les résultats obtenus à partir d’une méthode, les potentiels évoqués. Cette méthode permet de déterminer si la signature sur le scalp de deux processus impliquant, pour l’essentiel, des structures néo-corticales, sont qualitativement différents. Il est, en effet, fortement improbable que des configurations neuronales identiques donnent lieu à des effets électrophysiologiques différents. En revanche, il reste pour différentes raisons, et notamment celles liées au problème inverse décrit dans la partie méthodes, difficile de déterminer si des effets électrophysiologiques similaires sur le scalp résultent de la mise en jeu de configurations neuronales identiques ou différentes. Il est donc tout à fait important d’utiliser d’autres méthodes d’imagerie cérébrale pour valider ces interprétations.

En conclusion, la méthode des PEs permet de déterminer précisément, à partir de quel moment les tracés enregistrés dans deux conditions expérimentales divergent. Par inférence, on peut donc en déduire à partir de quel moment les processus impliqués dans le traitement de deux ou plusieurs types de stimuli, ou ceux impliqués dans la réalisation de deux ou plusieurs tâches, diffèrent. Il est néanmoins indispensable de compléter ces études par d’autres utilisant des méthodes qui offrent une excellente résolution spatiale, comme l’IRMf. Il deviendra alors possible de déterminer si les réseaux de structures cérébrales activés par les différents stimuli, ou les différentes tâches à réaliser, sont similaires ou différents. Les données obtenues avec ces différentes méthodes sont donc très complémentaires et permettront de mieux cerner la dynamique spatio-temporelle des processus impliqués dans la compréhension du langage et la perception musicale.

Glossaire

Harmonie : combinaison des notes pour produire des accords , et étude des principes structuraux qui déterminent ces combinaisons. Le contrepoint est l’art de combiner entre elles les lignes mélodiques

Mélodie : succession des notes en fonctions des conventions propres à une culture musicale

Sémantique : étude du sens

Phonologie : étude des sons à valeur distinctive (phonèmes) utilisés dans une langue

Prosodie : étude des variations de hauteur, d’intensité, de rythme des mots et des énoncés

Syntaxe : étude des relations grammaticlaes entre les mots qui composent une phrase

Pragmatique : étude du langage du point de vue de son usage, de ses conditions d’utilisation et de ses fonctions communicatives

Références

• Arom S. 2000. Prolegomena to a Biomusicology. In The Origins of Music. N.L. Wallin, B. Merker & S. Brown, Eds. : 27-30. MIT Press. Cambridge, MA.

• Besson M. & Faïta F. (1995). An Event-Related Potential (ERP) study of musical expectancy : Comparison of musicians with non-musicians. Journal of Experimental Psychology : Human Perception and Performance 21, 6 : 1278-1296.

• Besson M., Faïta F., Czternasty C. & Kutas M. (1997). What’s in a pause : event-related potential analysis of temporal disruptions in written and spoken sentences. Biological Psychology 46 : 3-23.

• Besson M., Faita F., Peretz I., Bonnel A. M. & Requin (1998). Singing in the brain : Independence of lyrics and tunes. Psychological Science 9, 6 : 494-498.

• Chomsky N. (1957). Syntactic structures. Mouton & Co. The Hague, NL.

• Holcomb P. J., & Neville H. (1990). Auditory and visual semantic priming in lexical decision : A comparison using event-related brain potentials. Language & Cognitive Processes, 5, 281-312.

• Jackendoff R. (1994). Patterns in the mind : Language and human nature. Basic books. New-York.

• Jakobson R. 1973. Essais de linguistique générale. II. Rapports internes et externes du langage. Editions de Minuit, Arguments. Paris.

• Kutas M., & Hillyard S.A. (1980). Reading senseless sentences : Brain potentials reflect semantic incongruity. Science, 207, 203-204.

• Meyer L. (1956). Emotion and meaning in music. University of Chicago Press, Chicago.

• Osterhout L., & Holcomb P. J. (1992). Event-Related brain potentials elicited by syntactic anomaly. Journal of Memory and Language, 31, 785-804.

• Patel A., Gibson E., Ratner J., Besson M. & Holcomb P. (1998). Processing syntactic relations in language and music : An Event-Related Potential study. Journal of Cognitive Neuroscience, 10, 717-733.

• Pinker S. (1994). The language instinct : How the mind creates language. Harper Perennial.

• Robert S. (1997). Variation des représentations linguistiques : des unités à l’énoncé. In C. Fuchs & Robert S. (Eds), Diversité des langues et représentations cognitives (pp25-39). Ophrys, Paris. n é